Este blog técnico siempre ha orientado sus contenidos a compartir conocimientos en la materia o comentar situaciones cotidianas analizadas desde la perspectiva de la seguridad de la información.

Sin embargo he descubierto que con el paso del tiempo, también ha puesto en valor su capacidad de dejar constancia en el tiempo de mi forma de ver las cosas e incluso de la evolución profesional desde que llevo recogiendo entradas hace más de 20 años ya. Es por tanto un blog-log de mi vida profesional y de mi evolución personal que describe mi historia y mis cicatrices.

Hacía tiempo que tenía abandonada esta parcela de mi vida pero, estas últimas semanas, he tenido la oportunidad de disfrutar de suficiente tiempo y serenidad para poder ordenar el trastero de los pensamientos. Lo que voy a describir en esta entrada está relacionada con el proceso de gestión de incidentes /crisis pero contextualizado al ámbito personal, explicando mi propia experiencia sobre lo vivido en estas últimas cuatro semanas y cómo contar con herramientas de nuestra disciplina me han sido muy útiles. En la vida es importante tropezar y aprender de las cicatrices que el cuerpo va recogiendo para evolucionar. Quizás contarlo y comentar lo que para mí han sido factores clave que han permitido llevar mejor este tipo de situaciones, permita a otros recoger algunas ideas que puedan aplicar en su caso concreto.

Esto además encaja con la última de las actividades del proceso de gestión de incidentes, en donde una vez finalizada la batalla, toca analizar, reflexionar y recapitular bajo la fase de "lecciones aprendidas". He valorado durante varios días hasta dónde llegar a ser transparente respecto a mis emociones... y lo que a continuación describo lo hago con conocimiento de causa. Comenzamos...

Gestión de incidentes de ciberseguridad.

La mejor propuesta de procesos y referencia principal la estableció "NIST 800-61 Computer Security Incident Handling Guide" allá por 2012. Las actividades del proceso quedaban establecidas en 4 fases principales, donde la primera de ellas era propia de diseño y el resto ya operativas cuando el incidente se produce. El siguiente gráfico muestra de forma sencilla estas actividades y simplifica de forma bella la propia naturaleza de estas actividades. Como puede verse, el feedback es constante, tanto entre las fases operativas (detección/analisis y contención/erradicación/recuperación) como entre las fases iniciales y finales (ajustes desde las lecciones aprendidas hacia el propio diseño del proceso para asegurar la mejora continua.

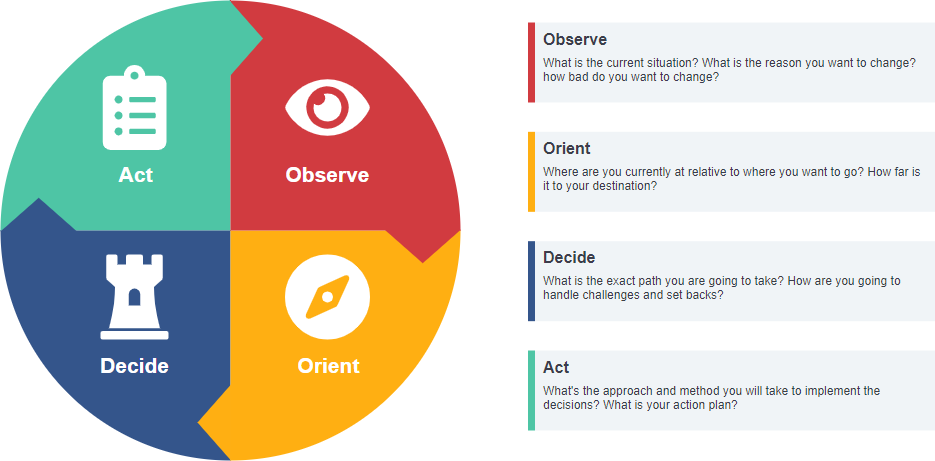

Todo esto cobra sentido cuando se identifica claramente que la toma de decisiones en un entorno dinámico sometido a incertidumbre debe basarse en un ciclo de gestión retroalimentado basado en el OODA LOOP.

Esta dinámica de trabajo permite en todo momento estar estudiando la información de entrada, obtener conciencia situacional para identificar riesgos, situación, respuesta de ajuste para minimizar consecuencias y respuesta para lograr variar o revertir los riesgos identificados.

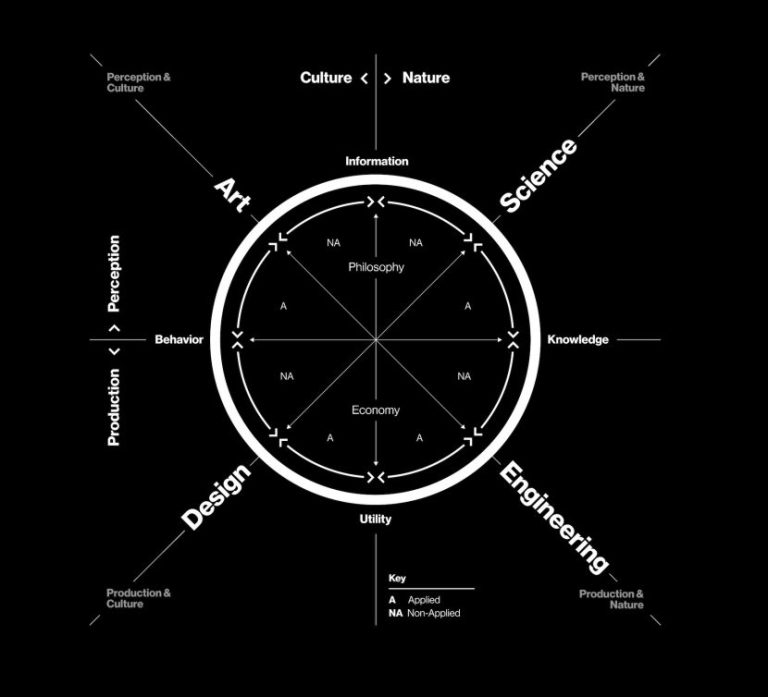

Una vez realizada esta pequeña exposición teórica, ahora vamos a iniciar la reflexión más intima de cómo es posible emplear conocimientos de unas disciplinas en otras para obtener nuevos enfoques a la hora de resolver problemas. Es lo que denominamos Hibridación de disciplinas como base para la innovación que aplico constantemente que detecto algún patrón.

Contexto de situación.

Como pequeña descripción de contexto debo decir que estas dos últimas semanas (desde primeros de mayo de 2022 para contextualizar puntualmente el momento en el blog) estoy de baja por enfermedad. Aunque continuo en proceso de diagnóstico y valoración de daños, un virus no informático hackeó mi oído interno causando daños en el sistema del equilibrio y el sistema auditivo del hardware afectado (lado izquierdo) con degradación casi completa de la audición. Ello, acompañado de unos síntomas severos de vértigo que inutilizaban el sistema locomotor, la capacidad de mantener la verticalidad y andar de forma normal y generaban colateralmente una denegación de servicio del sistema digestivo que expulsaba cualquier solido o liquido que quisiera procesar. En resumen, una degradación completa que sólo me permitía estar en cama tumbado sin casi poder probar alimento durante 3 días. Vista la situación y su severidad, tuve que acudir a urgencias para una valoración del estado. En una primera visita, los síntomas eran severos y se empezó a administrar medicación inicial de contingencia para arrancar primeras fases del tratamiento y posteriormente al día siguiente, con una valoración también ya completa de la degradación del sistema auditivo izquierdo, se procedió al ingreso hospitalario inmediato.

El tratamiento requería dosis fuertes de medicación una vez al día y la realización de una prueba relevante de diagnóstico por imagen con el objetivo de analizar el estado de situación de la zona del oído interno (donde residen los huesos más pequeños del cuerpo humano) mediante resonancia magnética.

Como dato relevante, con 48 años en este momento, no había pasado todavía en mi vida hasta esta fecha una sola noche ingresado en un hospital. Mantenía una ficha en blanco como usuario de la sanidad española en atención hospitalaria. Por tanto, todo lo que iba a vivir desde ese momento en adelante era nuevo para mi, visto desde dentro y no desde la posición de acompañante que había sido siempre mi rol en estos temas.

El proceso de gestión de incidentes llevado al ámbito de la salud.

A continuación pretendo ir reflejando algunas reflexiones que estuvieron en mi cabeza en cada momento y que ayudaron a una mejor canalización de todo lo que estaba pasando. Esta es la experiencia que comparto por si puede ser de ayuda a cualquier que haya llegado a leer hasta aquí. No ha sido fácil valorar el coste/beneficio de mostrar esta parte tan intima … pero si en algo puede ayudar, merecerá la pena.

Fase de detección.

Tras llamar al médico de urgencias y administrarme medicación para el cese del vómito, al día siguiente de nuevo viene otro médico para valorar los nuevos síntomas y me proporciona medicación para el vértigo. Solo estaba tranquilo totalmente tumbado pero no podía ingerir alimento y casi nada de líquido porque enseguida lo volvía a vomitar. Según lo comentado por el doctor, en un par de días debía mejorar o habría que ver qué pasaba. Llega el miércoles, la cosa no mejora y la sensación de vértigo me impide andar con normalidad porque todo me da vueltas. Es en ese momento cuando noto ya de forma relevante una pérdida auditiva severa en el oído izquierdo y el acúfeno interno mucho más intenso. Consulto con mi hermano que es médico ( urólogo) y me comenta que ya hay que acudir a urgencias. La cosa no ha evolucionado y los síntomas ya no son algo llevadero. En este caso, contar con un asesoramiento especializado que valore los síntomas y establezca el nivel de urgencia fue esencial para atajar a tiempo los eventos detectados.

Como reflexiones respecto a la gestión de incidentes en esta fase de detección, es importante tener en consideración las siguientes cuestiones:

- Inventariar cualquier situación o evento significativo que adquiera carácter de anómalo o de indicio o sospecha vinculable al incidente. En la fase de detección hay que tratar de reunir la máxima información que permita en la siguiente fase un mejor diagnóstico.

- Tener o identificar criterios de severidad para decidir cuándo el incidente está evolucionando negativamente y va a requerir un escalado o una nueva valoración de la severidad. La toma de decisiones debe ser proporcional a los umbrales que se van identificando y debe estar clara cuál es la línea roja que activa la "contingencia" o "crisis". En mi caso, había síntomas que ya hacían necesario acudir a urgencias para escalar el diagnóstico de forma urgente y recibir una atención más especializada.

Fase de análisis o triaje.

Con esta descripción de situación ya me hago una composición de lugar. Hay "evidencias" que me permiten saber cuál será el contexto de los próximos días aun sin todavía tener claro el diagnóstico. Hago inventario de "certezas" y valoro contexto y decisiones a tomar:

- Voy a pasar al menos una semana ingresado. Hay que planificar la logística con la familia para que las rutinas habituales y el día a día de mis hijos sea impactado lo menos posible.

- Las analíticas no tienen valores raros, salvo cuestiones relacionadas con la medicación. He de destacar aquí el papel que también ha tenido el acceso a los datos clínicos que permiten los sistemas de información del Servicio Murciano de Salud. Desde hace tiempo, tenemos vía aplicación movil o página Web acceso al portal del paciente. En este entorno, a través del servicio Ágora, el ciudadano tiene acceso a todos los informes y documentos clínicos que se van generando. Esto me permitía descargarme tanto las analíticas como los informes de valoración que me iban entregando en consulta. En cierta forma, iba pudiendo conocer resultados que luego los médicos me valoraban al pasar consulta. Esta accesibilidad ha sido un punto positivo a destacar.

- La resonancia es una prueba clave para el diagnóstico. Hasta ese día no se podrá conocer la gravedad del asunto y por tanto, toca esperar. Este quizás fue el punto crítico, porque la "severidad del incidente" según resultado podría dispararse a niveles muy altos. Es aquí cuando aparece en escena la palabra "tumor, normalmente benigno" como posible origen de un brote tan severo e inmediato. Hasta ese día no se podrá saber si el origen está vinculado con ese diagnóstico.

Como reflexiones respecto a la gestión de incidentes en esta fase de triaje, es importante tener en consideración las siguientes cuestiones:

- Es esencial valorar la situación en base a los "hechos confirmados" y las "evidencias reales". En mi caso había potenciales hipótesis que podrían llevarme a escenarios más complicados... pero adelantar acontecimientos y situaciones futuras no iba a sumar. Por tanto, cabeza fría y ajuste de la valoración de la situación a lo que es "cierto en el momento en el que se decide todo". Es en ese momento cuando recurro a uno de las imagen-fuerza que me acompañarán estos días. Importa el hoy y el mañana. El pasado sirve para retroalimentar conductas y aprender de errores.

- Hay que asimilar rápido los cambios. El futuro no es como uno quiere sino como se presenta. Por tanto, es posible que tenga que convivir en el futuro con una merma auditiva. Tengo que empezar a valorar en qué va a afectar e iniciar los cambios que sean necesarios para poder convivir con esta nueva situación. Como acción inmediata ya he adquirido un nuevo monitor con altavoces y micro incorporado que ya no requiere utilizar cascos. Además al ser panorámico, minimiza el movimiento de cabeza y hace mucho más cómodo todo. Mi nuevo setup asegura una mayor ergonomía y comodidad en esta nueva situación.

- En relación a la gestión de incidentes, implica que hay que valorar qué se tiene y qué se debe conseguir tener para tener mejores herramientas en las fases siguientes del incidente, donde habrá que poner la carne en el asador: "contención, erradicación y recuperación". Qué bien me había venido también leer recientemente el libro de Maite Moreno "Gestión de incidentes de ciberseguridad" porque había repasado recientemente todas estas actividades. Yo conozco perfectamente la norma de referencia ISO 27035 porque en Govertis soy formador en esta materia. Doy clases de gestión de brechas de seguridad en los cursos a DPD de la certificación DPD de AEC y también he ido profundizando en la materia para dar soporte en consultoría tanto al diseño de procedimientos de gestión de incidentes/crisis como a ejercicios de escritorio Table Top Exercise (TTX) de los que ya he diseñado y ejecutado varios simulacros para organizaciones muy relevantes del ámbito nacional de sectores tan críticos como el energético o el financiero. Este "expertis" me estaba dando herramientas intelectuales de gestión de la situación de un valor incalculable. A esta mochila profesional tengo que añadir que en mi época universitaria también fui educador de los scout y tuve que enfrentarme a un par de accidentes severos con evacuaciones de emergencia que me hicieron ver cómo en situaciones de crisis, en vez de caer en pánico, surgía de mi una serenidad y una tranquilidad para tomar decisiones que no imaginaba poseer. Estas "soft skills" que no se enseñan, son capacidades que en ciertos momentos hacen muy diferente a las personas y sus reacciones.

- Comunicar la situación a partes interesadas directamente afectadas. Esta es una actividad de gestión del incidente que discurre en paralelo a las acciones técnicas de valoración y toma de decisiones pero "ESENCIAL" durante todo el proceso. Tal como se determina en la norma de gestión de incidentes, es necesario realizar un inventario de "partes interesadas" y tener claro para cada una de ellas los siguientes puntos:

- Expectativas de comunicación y frecuencia de contacto.

- Canales de comunicación a emplear.

- Mensajes

- En este caso, tuve de nuevo un golpe de suerte. El hospital es universitario y tenía desplegada la red Eduroam, por lo que tenía internet sin límite mientras estuviera ingresado. No me iba a faltar ancho de banda. Por ese motivo, me llevo la Tablet de mi hija al hospital que me permite tener aplicaciones de ocio y televisión pero la suite O365 para tener acceso a Teams y correo y poder seguir participando de algunas cosas que estaban en curso o apoyando a compañeros al menos en reuniones. Todo ello con la prudencia adecuada de evitar que estos comportamientos pudieran agravar la situación, pero no me habían contraindicado nada al respecto. Además estar activo me mantenía distraído e hizo que los días jueves, viernes, lunes y martes pasaran más rápido. Tenía la cabeza ordenando cosas del trabajo y la vida aprovechando la pausa forzada.

- Respecto al inventario de partes interesadas, era fácil:

- Familia: mis hijos fundamentalmente tenían que ver la situación como algo temporal, incomodo pero poco relevante. Debían verme como siempre pero sin poder tener contacto presencial. Por suerte hoy en día con la videollamada y la mensajería, el contacto es continuo y la "sensación de proximidad" puede ser tan intensa como se quiera.

- Jefes y compañeros: trasmitir la potencial duración de la situación para que se tomaran medidas de ajuste y mucho optimismo porque estaba todo controlado. En este caso además, recibía el apoyo tanto de ellos como de los compañeros con los que tenía interacción.

- En relación al uso de la tecnología, hay que maximizar los beneficios que nos proporcionan nuestros nuevos medios y las posibilidades que permiten de jugar con ellos. Para quitar hierro al asunto cuando hablaba con mis hijos (11 años) siempre usaba las capacidades de Facetime para gastarles bromas durante la conversación. Las situaciones no son realmente como ocurren sino como se perciben y el humor es una varita mágica que hace maravillas en este aspecto. El canal puede complementar al mensaje y condicionan mucho la percepción de lo que está ocurriendo.

Fase de contención, erradicación y recuperación.

Actualmente puedo decir que estoy en esta fase. Todavía tengo pendientes, en esta semana que entra, el paso por consulta para la realización de nuevas pruebas de valoración de la audición que proporcionará nueva información. En concreto, se identificará si hay una situación de estancamiento o de mejora y los siguientes pasos. En cualquier caso, en estos momentos lo importante es, de forma proactiva, hacer todo aquello que pueda suponer una mejora o permita avances en la recuperación. La actitud a mantener, dosificando fuerzas es siempre de ir subiendo escalones... porque con el tiempo, la distancia recorrida será mucha.

Como reflexiones respecto a la gestión de incidentes en esta fase de contención, erradicación y recuperación, es importante tener en consideración las siguientes cuestiones:

- Identificar los roles a involucrar en donde cada miembro sume su máximo potencial. No todos tenemos capacidades para todo tipo de actividades pero repartiendo bien los roles, se cubren muchos frentes y cada miembro del equipo de respuesta frente a incidentes (ERI) o gestión de crisis (Comité de crisis) puede aportar. Las capacidades requeridas en estos equipos son muy variadas:

- Capacidades técnicas vinculadas al tipo de incidente y los conocimientos necesarios para tomar decisiones sobre las actuaciones de contención, erradicación y recuperación.

- Capacidades de gestión y tomas de decisiones.

- Capacidades de comunicación.

- Capacidades de realizar el seguimiento y registrar a modo de bitácora lo que va aconteciendo para posteriormente tener claro el time line del incidente.

- Capacidades de motivación y coordinación para gestionar al equipo, su cansancio y su descanso.

- Tener claro los criterios que deben priorizar la toma de decisiones en cada momento:

- Contención: cortar la hemorragia, resolver el problema o lograr minimizar tanto el tiempo de daño como sus consecuencias. El foco en esta fase se sitúa en parar cuanto antes la causa de daño. Cuando el incidente tiene naturaleza de "one shot", es decir, el impacto inicial es inmitigable, la contención en estos casos debe velar por poder contrarrestar los efectos negativos del incidente. En seguridad de la información, cuando hablamos por ejemplo de "fugas de datos" donde el daño se vincula a la confidencialidad, no existirá reparación posible. Lo que habrá en estos casos que valorar es la viabilidad, si fuera posible, de revertir o hacer caducar la información filtrada para que su impacto sea menor. Esto por ejemplo aplica en fugas de contraseñas o hashes donde el valor de la información lo proporciona la propia información pero ésta puede ser renovada o hacerla caducar.

- Erradiación: el foco aquí se centra en observar qué respuesta van teniendo las acciones que vamos tomando y si vamos logrando que la situación esté controlada y empecemos a revertir los daños. Según la naturaleza del incidente, en erradicación lo que buscamos es tratar de eliminar el origen y limpiar los entornos afectados haciéndolos llegar a un "estado de confianza" anterior al incidente que permita pasar a la fase de recuperación con garantías de no volver un paso atrás o con la tranquilidad de que el agente agresor ya no tiene control o posibilidad de acceso al entorno afectado.

- Recuperación: con las fases anteriores ya finalizadas, en este momento se inicia la normalización al momento anterior al incidente para dejar las cosas como al principio. De nuevo, según la naturaleza del incidente, las acciones técnicas a realizar permitirán mas o menos lograrlo. Estará también esta fase condicionada por los resultados de las medidas preventivas y de recuperación que hayamos desplegado de forma previa y la fiabilidad de sus resultados. En esta fase es esencial la adecuada estrategia de backup que la organización hubiera establecido y sobre todo, las garantías de que este proceso fuera fiable y contara con garantías que eviten llegado a este momento, que lo que era una salvaguarda se convierta en un fracaso que aumente el impacto inicial del incidente. En muchos casos de ransomware el drama no llega cuando se detecta la afectación sino cuando se descubre que el backup está afectado y no podrá ser utilizado como salvaguarda.

Fase de lecciones aprendidas.

Finalmente, una vez acaba la batalla, pero sin dejar excesivo tiempo para el olvido, es importantísimo hacer el ejercicio de revisión y valoración de todo lo ocurrido. Es en parte el objetivo de todo esto que he escrito hasta aquí, y la forma de pasar página saliendo más fuerte. Cuando imparto formación en gestión de incidentes y la transición a crisis, me gusta siempre comenzar con esta imagen que describe bien lo que debe significar "lecciones aprendidas". En japonés crisis tiene dos símbolos con palabras que parecen antónimas: peligro/oportunidad. No había identificado hasta ahora lo cierto y relevante que es la palabra "oportunidad" vinculada a crisis. Como se suele decir, todo tropezón supondrá heridas... pero lo peor de todo sería no aprender.

La fase de “lecciones aprendidas” es de feedback completo

sobre todo lo establecido y de identificación de desviaciones o ausencias

relevantes que hayan podido condicionar la correcta ejecución. Es por eso que la flecha de feedback va desde "lecciones aprendidas" a "preparación", porque es en esa fase donde se realiza el diseño de todo el proceso y se describen todas las actividades del resto de fases.

El objetivo es garantizar que una siguiente ejecución tiene

como punto de salida una mejor capacidad de respuesta a partir de lo ya ocurrido e identificado.

Cuestiones vinculadas al proceso, la coordinación y la comunicación:

- Definición de roles,

asignación clara de responsabilidades, localización de las personas,

protocolos de coordinación.

- Revisión de actividades: En este caso, si se puede segmentar el análisis en las fases de gestión. Valorar qué hay que cambiar o mejorar respecto a:

- Detección.

- Análisis y valoración.

- Contención

- Erradicación

- Recuperación

- Valoración de herramientas: necesidades detectadas que no están cubiertas, entornos o herramientas que habrían supuesto una ayuda de haber podido contar con ellas.

Como vemos, esta fase debe generar un informe final de ajuste que permita la retroalimentación hacia todas las fases existentes realizando ajustes frente a desviaciones o ausencias de criterios o de oportunidades de mejora para limar fallos. A lo largo de este post me he ido ayudando de Liz Fosslien, una dibujante que tiene la capacidad de mostrar desde la sencillez los pensamientos clave que hacen robusto el proceso de mejora y superación. Tengo pendiente adquirir su libro porque como habréis podido comprobar, sus ilustraciones tienen una "energía de comunicación brutal". Para que la podáis tener localizada, esta es su web.

Toca terminar con esta imagen que también resumen bien todo lo anterior. En situaciones difíciles solo tenemos dos caminos: el bloqueo o pánico o la reacción serena para coger al toro por los cuernos y tratar de evolucionar para salir del agujero. No vas a poder cambiar los hechos pero si puedes controlar el cómo los vayas a afrontar.

Tener unos pilares fuertes, una "familia" que actúa como red de cobertura y apoyo que hace fácil lo difícil y tratar en cada momento de sumar al máximo son las claves del éxito. En mi caso, todo ha sido viento a favor que ha hecho todo más llevadero... y ha generado una dinámica positiva que ha contribuido a acelerar para bien todo.

Espero que esto sirva para dar herramientas a quien en algún momento se vea en situaciones parecidas o extrapolables a la experiencia contada. Nos gusta pensar que andamos por la vida atravesando grandes avenidas pero en realidad, cada paso que damos siempre lo hacemos en una cuerda floja. De repente la vida nos pone en contexto y nos hace ver "lo anómalo que es la tranquila normalidad que vivimos cada día".

La vida nos fuerza en muchas ocasiones a parar. Con cierta sabiduría, creo que las cosas no pasan por azar sino que llegan en momentos que es necesario detenerse a reflexionar. En mi caso, estas tres semanas han sido de auditoría interna del camino recorrido y ha sido gratificante ver que solo hay “oportunidades de mejora” pero ninguna desviación ni no conformidad. Estoy donde quiero estar, con todo en su sitio y equilibrado. Hace días Bernardo Quintero escribía una frase que suscribo, “la vida me ha enseñado que se puede perder ganando y ganar perdiendo”. A lo largo de mi carrera profesional he tomado decisiones donde lo familiar o personal ha primado sobre lo profesional. Decidí salir de Madrid cuando no compartía ese ritmo acelerado de vida con mi carácter, salir de Almería trabajando para una entidad financiera y aterrizar en una pyme para montar el area de seguridad de la información. Ahora, disfruto de mi ciudad, un entorno tranquilo donde mis hijos tienen sus rutinas, van a mi mismo colegio y tienen un ambiente adecuado. Estas cosas no tienen precio… pero sigo trabajando en lo que me gusta, con cada día más vocación y pasión y ahora, en Govertis/ Telefónica Tech con proyectos increíbles de altísima complejidad que jamás habría podido soñar tener y sin salir de casa. Hay que valorar lo que se tiene y disfrutarlo. Como dice el proverbio popular "No hay paraíso hasta que se ha perdido".

- Follow Us on Twitter!

- "Join Us on Facebook!

- RSS

Contacta por Linkedin