El caso es que en la rueda de preguntas una de las que se lanzó fue la que da título al post, ¿si tengo un IDS o IPS, para qué quiero un gestor de vulnerabilidades? En este post quiero dar mi opinión al respecto.

Lo primero que quiero hacer es dibujar el escenario de batalla. Joseba Enjuto lo definió muy bien en su post El universo de las amenazas y que queda resumido en el juego de palabras "Lo que sé que sé, lo que sé que no sé, lo que no sé que sé y lo que no sé que no sé". Tal como explica Joseba, serían estos cuatro cuadrantes.

- Sector 1: Probable y conocido. Este es nuestro mayor campo de actuación y el que definimos tradicionalmente como la gestión “convencional” de la seguridad. Es el enemigo que viene de frente y que sabemos que hay que combatir a diario. Entrarían las rutinas de protección frente a virus, accesos no autorizados y en este cuadrante suelen estar desplegadas el mayor número de las medidas que suelen existir en una organización.

- Sector 2: Improbable y conocido. Este es el área en la que los fenómenos que se suceden, por la falta de costumbre, nos sorprenden. Aquí somos nosotros mismos quienes decidimos limitar nuestra capacidad de predicción. Este sería quizás uno de los cuadrantes donde habría que meter la gestión de las vulnerabilidades. Al fin y al cabo, la gran parte de las vulnerabilidades son conocidas y disponen de parche. Es nuestra tarea cerrar estos agujeros potenciales dentro de nuestra organización para que, aunque parezca improbable, a nuestro enemigo no se le ocurra hurgar donde no debe.

- Sector 3: Probable y desconocido. Aquí entra la osadía del individuo en juego para ser capaz de romper la barrera del conocimiento actual y ponerlo a disposición del resto, es lo que se viene conociendo comúnmente como “descubrimientos”. En este sector es donde más valor proporcionan las herramientas de descubrimiento de vulnerabilidades y de errores de configuración. Este sería el otro cuadrante donde encajar la gestión de vulnerabilidades dado que muchas herramientas sirven también para auditar que no se dan ciertas circunstancias o que los sistemas no se encuentran mal configurados.

- Sector 4: Desconocido e Improbable. Todo aquello que pasa al lado de nuestra existencia sin siquiera percibirlo y que además la probabilidad de que suceda a pesar de nuestro desconocimiento es mínima. En este cuadrante se situarían las temidas y famosas "vulnerabilidades zero-day" que mientras permanecen ocultas y sin ser conocidas por los fabricantes, son un peligro para todos aquellos que no disponen de una monitorización preventiva del uso de sus sistemas. Puedes desconocer si eres o no vulnerable pero si puedes monitorizar su uso y descubrir que hay anomalías aun cuando desconoces lo que las causan.

La gestión de vulnerabilidades supone una actividad preventiva que intenta minimizar la posibilidad de sufrir un ataque. Se basa simplemente en ir cerrando aquellos errores o fallos que son dados a conocer por los fabricantes de los diferentes productos que podamos tener instalados y operativos en nuestros sistemas de información. En este caso, la base de datos de vulnerabilidades del producto que utilicemos es su mayor activo dado que sólo solventaremos aquellas vulnerabilidades que sean identificadas por el producto utilizado. Es por ello que se suele recomendar contrastar los falsos positivos e incluso cruzar resultados de varias herramientas.

La existencia de herramientas de detección y protección perimetral del tipo IDS supone una actividad de detección que intenta minimizar tanto la posibilidad de sufrir un ataque como su posible daño si consiguen pararlo. Cuando se trata de IDS se basan simplemente avisar que se producen intentos de ataque pero cuando estos ya se están produciendo. Cuando se trata de IPS además de lo anterior, se intenta responder o reaccionar también a los ataques que están produciendo. En este caso, la fiabilidad del dispositivo es muy importante dado que sólo evitaremos aquellos ataques que el sistema detecte bien sabiendo que ya los intentos de agresión se están produciendo. Los tiempos de reacción también son más cortos en este caso.

La gestión de vulnerabilidades por tanto, permite a los responsables de sistemas planificar y programar sus actividades de mantenimiento para hacer las cosas cuando ellos consideran siempre que las vulnerabilidades detectadas no están siendo empleadas en oleadas masivas de ataques como ocurrió con malware como Downadup o Conficker. Incluso en aquel caso, la vulnerabilidad explotada tenía una antigüedad de varios meses por lo que quien hiciera una gestión eficiente de vulnerabilidades podía ser inmune al ataque cuando se popularizó su explotación por parte del malware específicamente diseñado.

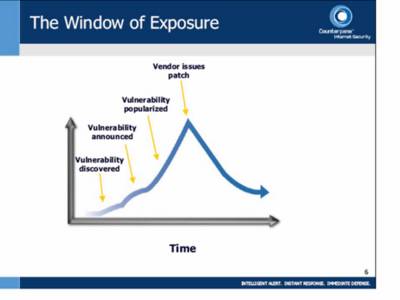

Aquí es cuando es útil de nuevo recordar lo que ya expuse en el post "La ventana de exposición" y "Explotar vulnerabilidades y la ventana de exposición".

La ventana de exposición es el tiempo transcurrido entre la publicación de la vulnerabilidad y la aplicación del parche y es el periodo que intenta minimizar toda gestión de vulnerabilidades, hacer que la ventana de exposición tienda a cero.

Y respondiendo a la pregunta que da titulo al post, la elección debe ser ambas estrategias. La estrategia de gestión de vulnerabilidades como una actividad más de la operación de la seguridad sobre los sistemas de información y las herramientas IDS o preferiblemente IPS como un control complementario para evitar cualquier otro incidente que pudiera ser peligroso y que no consista en explotar exactamente una vulnerabilidad.

Si hubiera que elegir sólo una de ellas, dependerá de cada organización y cómo de preocupante sea tanto lo que pudiera ocurrir si hay una intrusión como lo frecuentes que son los intentos de ataque detectados para optar por prevenir o detectar. De nuevo es de aplicación la gran máxima de "El arte de la guerra" que dice "Conoce a tu enemigo y conócete a ti mismo; en cien batallas, nunca saldrás derrotado. Si eres ignorante de tu enemigo pero te conoces a ti mismo, tus oportunidades de ganar o perder son las mismas. Si eres ignorante de tu enemigo y de ti mismo, puedes estar seguro de ser derrotado en cada batalla."

En este caso, la gestión de vulnerabilidades se centra en conocernos a nosotros mismos. Al menos, supone el 50% de lograr la victoria.

Y para quien quiera ver lo común y habitual es que las Webs sean hackeadas, en la Web Zone-h llevan un histórico de las páginas que han sido hackeadas y notificadas. Como podéis comprobar hay decenas de registros a diario e incluso podéis consultar por dominios para ver cómo de habitual es este tipo de incidentes. Seguro que os sorprende comprobar cómo han caido algunas Webs. En los enlaces mirror se encuentra la captura de pantalla que evidencia que la Web fue hackeada, aunque posteriormente haya podido ser restablecida.

- Follow Us on Twitter!

- "Join Us on Facebook!

- RSS

Contacta por Linkedin